L’évaluation des apprentissages informels en contexte muséal

Par les équipes Ingénium

Vous souvenez-vous d’une sortie au musée lorsque vous étiez enfant? Quelles expériences y avez-vous vécues? Qu’est-ce qui vous a le plus marqué dans votre visite?

Cette expérience éducationnelle non formelle qui fait notre renommée est d’ailleurs la principale raison mentionnée par les parents et enseignants pour organiser une visite. Ils désirent élargir les horizons de leurs enfants ou élèves et leur faire découvrir de nouvelles perspectives scientifiques et pédagogiques avec une approche tant amusante qu’éducative.

Nos ateliers scolaires et publics ont une durée d’une dizaine de minutes à quelques heures. Ils doivent donc rapidement avoir un impact. Par des expériences pratiques, nous exposons les visiteurs à une panoplie d’activités STIAM, passant de l’essai d’un siège d’avion éjectable à la création d’un toutou électronique ou à la confection de pains. Notre défi est le suivant : comment savoir si nos objectifs d’apprentissages sont atteints dans un contexte d’éducation informel?

Les objectifs d’apprentissage

Tous les programmes et activités élaborés aux musées nécessitent des objectifs d’apprentissage définis, sans quoi nous ne serons pas en mesure de mesurer leur impact. Ces objectifs sont basés sur l’expérience que vivront les participants lors de leurs visites. Nous incorporons bien sûr des éléments des curriculums, mais d’autres angles pédagogiques sont considérés, dont les compétences sociales, socioémotionnelles et celles dites du XXIe siècle, ainsi que la valeur expérientielle et ludique.

Il nous arrive cependant d’accrocher sur une idée d’expérience, comme la construction d’une machine à boules à faire soi-même, avant même d’avoir élaboré nos objectifs. Nous utilisons donc la méthode de conception à rebours de Wiggins et McTighe (Whitehouse, 2014) pour les élaborer. Cette méthode se décline en trois étapes, soit :

- Détermination des intentions d’apprentissage — qu’est-ce que les participants seront en mesure de faire?

- Validation des apprentissages — qu’est-ce qui nous démontrera qu’ils ont une compréhension du sujet?

- Animation et formation — quels choix ferons-nous pour amener les participants à être prêts à compléter le défi?

Cette méthode est aussi utile pour valider si une activité développée de façon régulière, soit en élaborant des objectifs pour ensuite déterminer les expériences, remplit son mandat ou pour confirmer que les liens entre chaque étape d’élaboration sont appropriés.

Avec nos objectifs en main, nous pouvons incorporer des éléments d’évaluations. Ces composantes, qu’elles proviennent du curriculum ou non, sont évaluées de façon indirecte.

Évaluer au fur et à mesure

Parce que les programmes sont courts, il faut rapidement évaluer si nos visiteurs retirent autant de leurs expériences que nous l’avons souhaité. L’observation des réactions des participants et des dynamiques de groupe est donc essentielle. L’écoute des questions posées et des discussions soulevées, avec nous ou entre participants, offre des pistes pour déterminer la profondeur de la compréhension. Cependant, l’observation n’est pas efficace avec tous les enfants, particulièrement ceux neurodiversifiés qui ne démontreront pas leur engagement de façon typique. Les boîtes de dialogue des plateformes en ligne ont remplacé l’observation directe et ont d’ailleurs favorisé l’inclusion de tous les participants.

Lors de nos interventions, nous favorisons les questions ouvertes non axées sur le savoir mais plutôt sur la réflexion. À l’occasion, nous employons des jeux-questionnaires pour remplacer le classique « est-ce que vous comprenez? », nous permettant ainsi de facilement évaluer si le groupe nécessite plus d’animation ou de cerner ceux requérant une aide individuelle.

Lorsque nous offrons une activité, nous prenons la perspective de l’animateur et non de l’enseignant pour créer un espace informel qui mise davantage sur l’exploration. Ceci est particulièrement applicable lors d’activités technocréatives de notre atelier Exploratek. Nous y proposons des défis en mettant l’accent sur la démarche de conception créative et non sur le produit final. Pour évaluer ce processus, nous utilisons le cadre conceptuel des dimensions de l’apprentissage mis au point par le Centre des sciences Exploratorium qui donne plusieurs pistes pour examiner de façon qualitative l’apprentissage en cours. Par exemple, un participant fait preuve de créativité et d’expression personnelle s’il fait des liens entre le défi et ses expériences ou intérêts, ou encore s’il cherche de nouvelles façons d’utiliser les matériaux. Une des façons les plus efficaces d’évaluer est d’ajouter des moments de réflexion et d’échange durant le programme, soit en faisant une pause et en initiant des discussions avec des questions ouvertes comme : « Qu'est-ce qui a le mieux fonctionné, et pourquoi selon toi? Qu'est-ce qui a influencé tes décisions? Si tu avais plus de temps, que changerais-tu? ». Ces questions donnent lieu à des introspections de la part des participants ainsi qu’à des analyses de leur expérience. Elles nous permettent aussi de mettre l’accent sur les bienfaits du processus itératif, le besoin de bien communiquer ses réalisations et la nature cyclique de la méthode scientifique.

Rétroaction

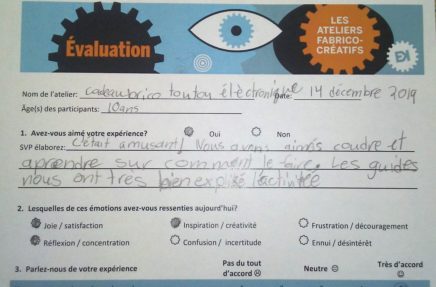

Après un programme, nous proposons des questionnaires aux parents et aux enseignants, et la perspective des élèves ayant fait l’expérience participative est toujours la bienvenue. Certains de nos questionnaires demandent aux participants quelles émotions ils ont ressenties lors de l’atelier. Le ratio d’émotions positives telles la joie, la réflexion et l’inspiration par rapport à celles qui sont négatives, comme la frustration, la confusion ou l’ennui, nous indique si des changements dans l’approche doivent être apportés. L’utilisation de l’application Flipgrid nous permet d’avoir de la rétroaction en vidéo qui est moins filtrée par nos perspectives, puisque les participants enfants et adultes reçoivent une invitation générale à discuter de leur expérience. L’application collaborative JamBoard nous permet aussi de mesurer l’engagement des participants.

Auto-évaluation

En éducation informelle, nous devons constamment nous évaluer, et jauger la portée des programmes pour être en mesure de déterminer si nos participants atteignent les objectifs d’apprentissage fixés. Des comptes rendus post-activité et des suivis sous forme de discussions en table ronde avec les guides qui présentent les programmes nous laissent entrevoir si les objectifs fixés sont réalisables dans la pratique. Cette information ainsi que l’analyse de la rétroaction des participants brossent un portrait des apprentissages qui ont eu lieu. À la lumière du déroulement des programmes, nous revisitons d’ailleurs souvent, en grande humilité, les objectifs d’apprentissage envisagés. Le fait d’offrir les programmes à répétition nous donne la possibilité de les raffiner. Cette approche itérative nous permet de nous ajuster rapidement aux attentes tant des adultes que des enfants.

Conclusion

Ces approches majoritairement basées sur des données qualitatives acquises durant et après les activités aident l’élaboration d’objectifs d’apprentissage efficaces et identifiables qui assurent aux participants la valeur de leur court temps passé avec nous. Et ce, dans le but de créer des occasions d'apprentissage approfondies pour nos visiteurs et éveiller leur curiosité à travers leurs expériences au musée.

Référence

Whitehouse, Mary (2014). Using a backward design approach to embed assessment in teaching. School Science Review. 95-99.

Les équipes de programmation de l'expérience aux visiteurs à Ingénium

AUTRES Articles DE LA THÉMATIQUE